هوش مصنوعی (AI) به سرعت در حال تغییر دنیای ماست. از تشخیص بیماری تا خودروهای خودران، این فناوری نویدبخش تحولات بزرگی است. اما هر پیشرفتی با چالشهایی همراه است، و امنیت هوش مصنوعی یکی از مهمترین دغدغههای عصر حاضر محسوب میشود. در این مقاله، به بررسی مشکلات امنیتی هوش مصنوعی میپردازیم و همچنین از تعریف امنیت هوش مصنوعی تا معرفی راهکارهای عملی برای مقابله با تهدیدات را بررسی میکنیم. همراه ما باشید تا دریابید چگونه میتوانیم این فناوری را به شکلی ایمن و مسئولانه به کار بگیریم.

امنیت هوش مصنوعی چیست؟

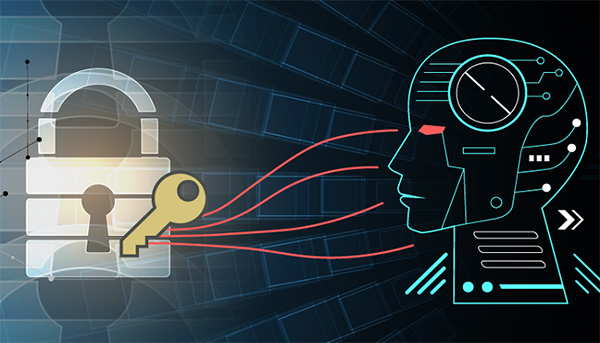

امنیت هوش مصنوعی به مجموعه اقداماتی گفته میشود که برای محافظت از سیستمهای مبتنی بر AI در برابر سوءاستفاده، حملات سایبری، و خطاهای ناخواسته طراحی شده است. این مفهوم از دو جنبه حفاظت از کاربران و مسئولیت ارائهدهندگان خدمات تشکیل میشود. این دو بخش مکمل یکدیگرند و نقص در هر کدام میتواند به آسیبپذیری کل سیستم بیانجامد. در ادامه، هر بخش را با جزئیات بیشتری بررسی میکنیم:

1. امنیت هوش مصنوعی برای کاربران

کاربران نهایی سیستمهای AI، مانند افراد عادی یا کسبوکارها، در معرض خطراتی مانند نقض حریم خصوصی، فیشینگ پیشرفته، یا تصمیمگیری ناعادلانه توسط الگوریتمها قرار دارند. امنیت در این حوزه به معنای محافظت از حقوق کاربران در سه حوزه کلیدی است:

الف. حریم خصوصی و محرمانگی دادهها

سیستمهای AI اغلب برای ارائه خدمات شخصیسازیشده، به دادههای کاربران (مانند تاریخچه جستجو، موقعیت مکانی، یا اطلاعات مالی) نیاز دارند. اما این دادهها میتوانند هدف حملات سایبری یا سوءاستفاده شرکتی قرار گیرند.

- مثال: یک دستیار صوتی هوشمند ممکن است به طور ناخواسته مکالمات خصوصی کاربر را ضبط و ذخیره کند. اگر سرورهای میزبان این دادهها ناامن باشند، هکرها میتوانند به آنها دسترسی پیدا کنند.

- راهکارهایی برای کاربران: استفاده از تنظیمات حریم خصوصی پیشرفته، پاک کردن دورهای تاریخچه دادهها، و اجتناب از اشتراکگذاری اطلاعات حساس با سیستمهای ناشناس.

ب. شفافیت و عدالت الگوریتمی

بسیاری از مدلهای هوش مصنوعی به دلیل تعصب در دادههای آموزشی، رفتارهای تبعیضآمیز از خود نشان میدهند. این موضوع به ویژه در سیستمهای استخدام، وامدهی، یا تشخیص چهره بحرانساز است.

- مثال: در سال 2023، یک سیستم AI مورد استفاده در غربالگری رزومهها، به دلیل تمرکز روی دادههای تاریخی مردانه، نرخ پذیرش زنان را تا ۳۰% کاهش داد.

- راهکار برای کاربران: پرسش درباره منطق تصمیمگیری سیستمهای AI (در صورت امکان) و گزارش رفتارهای مشکوک به نهادهای نظارتی.

ج. فریب سیستمهای AI توسط کاربران مخرب

کاربران ممکن است از فناوری AI برای اهداف مخرب مانند تولید دیپ فیک، حمله به سایرین، یا دستکاری الگوریتمها استفاده کنند.

2. امنیت هوش مصنوعی توسط ارائهدهندگان خدمات

ارائهدهندگان خدمات هوش مصنوعی (مانند شرکتهای فناوری، استارتاپها، یا مراکز تحقیقاتی) مسئول امنیت زیرساختها، مدلها، و فرآیندهای توسعه هستند. این بخش شامل چهار رکن اصلی است:

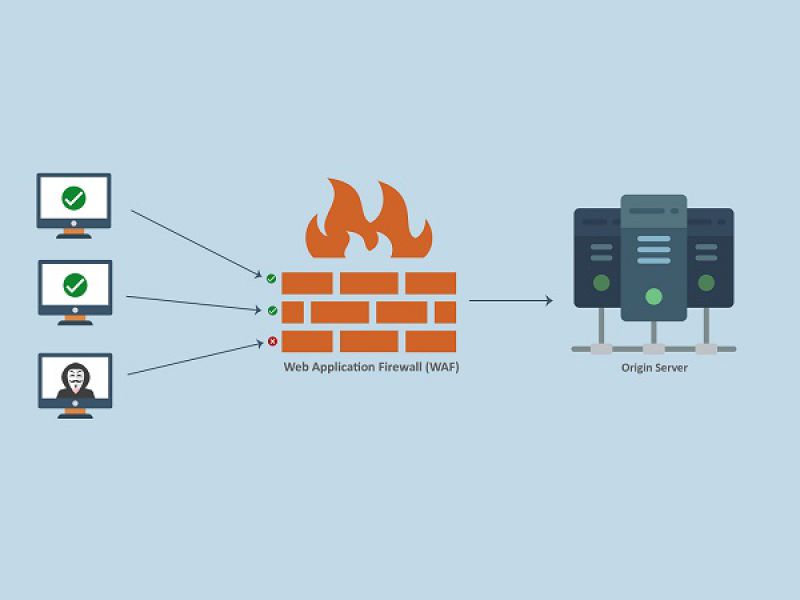

الف. امنیت سرورهای هوش مصنوعی و زیرساختها

سرورهایی که مدلهای AI را میزبانی میکنند، هدف اصلی حملات سایبری هستند. یک نفوذ موفق میتواند به سرقت مدلهای آموزشی، دستکاری خروجیها، یا قطع کامل سرویس منجر شود.

- مثال: در سال 2022، یک حمله سایبری به سرورهای یک شرکت رباتیک، باعث شد مدلهای کنترل کننده رباتهای صنعتی رفتارهای غیرقابل پیشبینی انجام دهند.

- راهکارهای ارائهدهندگان:

- استفاده از رمزنگاری end-to-end برای دادههای در حال انتقال و ذخیرهشده.

- به کارگیری فایروالهای مخصوص سیستمهای AI مانند مدیریت دسترسی مبتنی بر هویت (IAM).

- نظارت 24 ساعته بر ترافیک شبکه برای شناسایی فعالیتهای مشکوک.

ب. یکپارچگی مدلهای آموزشی و مقاومت در برابر حملات

مدلهای AI ممکن است در معرض حملات تخاصمی (Adversarial Attacks) قرار گیرند که با دستکاری ورودیها، خروجی را مختل میکنند.

- مثال: افزودن نویزهای نامحسوس به تصاویر پزشکی باعث تشخیص نادرست تومورها توسط سیستمهای AI میشود.

- راهکارهای ارائهدهندگان:

- آموزش مدلها با دادههای متنوع و شامل سناریوهای حمله.

- استفاده از تکنیکهایی مانند سختسازی مدل (Model Hardening) برای کاهش حساسیت به ورودیهای مخرب.

ج. اخلاق حرفهای و پاسخگویی اجتماعی

ارائهدهندگان موظفند سیستمهای AI را طوری توسعه دهند که علاوه بر عملکرد فنی، به ارزشهای اخلاقی پایبند باشد.

- مثال: شرکتهایی مانند OpenAI از چارچوبهای اخلاقی برای محدود کردن استفاده از مدلهای خود در تولید محتوای خشن استفاده میکنند.

- راهکارهای ارائهدهندگان:

- قراردادن بخشهایی برای نظارت بر پروژههای AI.

- انتشار گزارشهای شفاف درباره محدودیتها و خطرات مدلها.

د. انطباق با قوانین و استانداردهای جهانی

قوانینی مانند GDPR در اروپا یا AI Act ارائهدهندگان را ملزم میکند تا امنیت و حریم خصوصی کاربران را در اولویت قرار دهند.

- مثال: طبق GDPR، کاربران اروپایی حق دارند بدانند سیستمهای AI چگونه دادههای آن ها را پردازش میکنند.

امنیت هوش مصنوعی چه کاربردی دارد؟

امنیت هوش مصنوعی تنها به جلوگیری از هک شدن سیستمها محدود نمیشود. کاربردهای کلیدی آن عبارتند از:

- حفاظت از حریم خصوصی: جلوگیری از افشای غیرمجاز دادههای کاربران.

- پیشگیری از سوءاستفاده: مقابله با استفاده از AI برای تولید محتوای مخرب (مثل دیپ فیک).

- افزایش قابلیت اطمینان: اطمینان از عملکرد صحیح سیستمهای AI در شرایط واقعی.

- تضمین عدالت الگوریتمی: کاهش تعصبهای نژادی، جنسیتی یا اجتماعی در تصمیمگیریها.

چالشها و مشکلات امنیتی هوش مصنوعی

با وجود پتانسیل بالای هوش مصنوعی، چالشها و مشکلات امنیتی متعددی برای هوش مصنوعی وجود دارد که باید به آنها توجه کرد:

1. نقض حریم خصوصی و سوءاستفاده از دادهها

سیستمهای AI برای آموزش به حجم عظیمی از دادهها نیاز دارند. اگر این دادهها شامل اطلاعات شخصی باشند، کوچکترین آسیبپذیری در سیستم میتواند به نشت اطلاعات منجر شود. گزارش Trend Micro نشان میدهد که 47% از سازمانها در سال 2023 با نقض دادههای مرتبط با AI مواجه شدهاند.

2. حملات خصمانه(Adversarial Attacks)

حملات خصمانه شامل دستکاری ورودیهای سیستمهای AI برای فریب مدل و دریافت خروجی نادرست است. مثلاً تغییر چند پیکسل در یک تصویر میتواند یک سیستم تشخیص اشیا را به اشتباه بیندازد.

3. مدلهای متعصب و ناعادلانه

تعصب در دادههای آموزشی به تصمیمگیریهای تبعیضآمیز منجر میشود. برای مثال، یک سیستم استخدام هوش مصنوعی ممکن است به طور ناخواسته زنان را در اولویت پایینتری قرار دهد.

4. سوءاستفاده از فناوری AI

هوش مصنوعی میتواند برای اهداف مخربی مانند تولید خودکار بدافزار، هک کردن سیستمها، یا ایجاد محتوای جعلی مورد استفاده قرار گیرد.

5. پیچیدگی و عدم شفافیت مدلها

مدلهای پیشرفتهای مانند ChatGPT اغلب به عنوان «جعبه سیاه» عمل میکنند، که درک فرآیند تصمیمگیری آنها را دشوار میسازد. این عدم شفافیت، شناسایی و رفع آسیبپذیریها را چالش برانگیز میکند.

6. آسیبپذیری سرورهای هوش مصنوعی

سرورهایی که مدلهای AI را میزبانی میکنند، هدف جذابی برای هکرها هستند. یک حمله موفق میتواند به دسترسی غیرمجاز به دادهها یا حتی تخریب کامل سیستم بیانجامد. بنابراین یافتن سرور مناسب با امنیت بالا برای هوش مصنوعی مثل سرور گرافیکی اهمیت زیادی دارد.

7. کد های مخرب

خروجیهای هوش مصنوعی ممکن است برای کمک به اتخاذ تصمیمات مربوط به کسبوکار و کاربر و تصمیمات فنی مورداستفاده قرار بگیرند. این امر ریسک ضررهای مالی را ایجاد میکند و همچنین ممکن است عواقب امنیتی و قانونی داشته باشد. مثلاً کدهای ناامن زیادی در اینترنت وجود دارد، پس هر مدلی که روی اینترنت آموزش ببیند، ریسک ایجاد کدهای ناامن را به همراه خواهد داشت. اگر این کدهای ایجاد شده مستقیماً در یک پروژهی نرمافزاری مورداستفاده قرار گیرد، ممکن است تبدیل به یک حملهی زنجیرهی تأمین کاملاً جدید شود.

خروجیهای مدلهای هوش مصنوعی ممکن است در تصمیمگیریهای تجاری و فنی استفاده شوند، این موضوع با ریسکهای جدی مانند ضررهای مالی، تهدیدات امنیتی و چالشهای قانونی همراه است. از آنجا که این مدلها ممکن است بر پایه کدهای ناامن موجود در اینترنت آموزش ببینند، خطر تولید کدهای مخرب توسط آنها وجود دارد که در صورت استفاده در پروژههای نرمافزاری، میتواند به حملات زنجیرهای خطرناک تبدیل شود. بنابراین، ضروری است پیش از به کارگیری این فناوری، ارزیابی امنیتی دقیقی انجام شود.

تست امنیت و بنچمارک

درحالی که صنعت هوش مصنوعی بهسرعت در حال تکامل است، نیاز به استانداردهای جامع برای سنجش عملکرد و ایمنی مدلهای AI بیش از پیش احساس میشود. خوشبختانه، سازمانهای پیشرو در این زمینه گامهای عملی بلندی برداشتهاند که شایسته بررسی دقیق هستند:

1. MLCommons AI Safety: استانداردی نوین برای ارزیابی ایمنی مدلهای زبانی

گروه MLCommons با انتشار نسخه V0.5 از چارچوب AI Safety Benchmark، رویکردی نظاممند برای سنجش ایمنی مدلهای زبانی بزرگ (LLMs) ارائه کرده است. این استاندارد با تحلیل پاسخهای مدل به محرکهای متنی در دستهبندیهای متنوع (از جمله محتوای مضر، سوگیریهای اجتماعی و اطلاعات نادرست)، چارچوبی کمّی برای ارزیابی ریسکهای احتمالی ایجاد میکند. جالب است بدانید که این بنچمارک از مجموعهای از سناریوهای کنترلشده استفاده میکند که شامل بیش از 1000 مورد آزمایشی در 7 حوزه ریسک مختلف است.

2. NIST AI RMF 1.0: نقشه راه مدیریت ریسک هوش مصنوعی

مؤسسه ملی استاندارد و فناوری آمریکا (NIST) با انتشار چارچوب مدیریت ریسک هوش مصنوعی (AI RMF 1.0)، راهنمای عملیاتی جامعی برای سازمانها تدوین کرده است. این سند نهتنها به شناسایی و طبقهبندی ریسکها میپردازد، بلکه چهارچوبی گامبهگام برای اندازهگیری احتمال وقوع ریسکها، ارزیابی تأثیرات بالقوه، پیادهسازی مکانیزمهای کنترلی و نظارت مستمر ارائه میدهد. نکته حائز اهمیت این است که این چارچوب با استانداردهای بینالمللی مانند ISO/IEC 23894 همسو بوده و برای صنایع مختلف قابل تطبیق است.

3. Trusty AI: راهکاری متنباز برای مقابله با سوگیری در سیستمهای هوش مصنوعی

پروژه Trusty AI که توسط Red Hat راهاندازی شده، نمونه بارزی از تلاشهای جامعه متنباز برای حل چالشهای اخلاقی در AI است. این پلتفرم با ارائه مجموعهای از ابزارهای تشخیصی، به توسعهدهندگان کمک میکند:

- سوگیریهای الگوریتمی را در دادههای آموزشی شناسایی کنند.

- شفافیت (Explainability) مدلها را افزایش دهند.

- انصاف (Fairness) در خروجیها را اندازهگیری نمایند.

بر اساس مستندات فنی، Trusty AI از تکنیکهای پیشرفتهای مانند LIME و SHAP برای تفسیر تصمیمگیری مدلها استفاده میکند که این ویژگی آن را به ویژه برای کاربردهای حساس مانند سیستمهای اعتبارسنجی مالی یا تشخیص پزشکی ارزشمند میسازد.

تحلیل کارشناسانه:

این ابتکارات نشاندهنده تحولی اساسی در رویکرد صنعت به مسئله مسئولیتپذیری در هوش مصنوعی است. با این حال، چالشهای مهمی پیشرو وجود دارد:

- نیاز به هماهنگی بینالمللی برای ایجاد استانداردهای یکپارچه

- ضرورت توسعه ابزارهای ارزیابی برای مدلهای چندوجهی (Multimodal)

- اهمیت توجه به تفاوتهای فرهنگی در تعریف معیارهای اخلاقی

کارشناسان پیشبینی میکنند که در 5 سال آینده، رعایت این استانداردها از حالت داوطلبانه خارج شده و به بخش الزامی فرآیند توسعه سیستمهای هوش مصنوعی تبدیل خواهد شد.

راهکارهای افزایش امنیت هوش مصنوعی

مقابله با مشکلات امنیتی هوش مصنوعی نیازمند همکاری همه ذینفعان است. در این بخش، راهکارهایی برای هر دو گروه کاربران و ارائهدهندگان خدمات AI ارائه میشود:

راهکارهایی برای کاربران

۱. آموزش و آگاهی: کاربران باید با خطرات احتمالی هوش مصنوعی آشنا شوند. مثلاً از به اشتراک گذاری اطلاعات حساس با چتباتهای ناشناس خودداری کنند.

۲. استفاده از ابزارهای رمزنگاری: ابزارهایی مانند VPN یا رمزگذاری پیامها میتوانند حریم خصوصی را تقویت کنند.

۳. بررسی تنظیمات حریم خصوصی: در پلتفرمهای مبتنی بر AI، تنظیمات مربوط به اشتراکگذاری دادهها را محدود کنید.

راهکارهایی برای ارائهدهندگان خدمات AI

۱. استفاده از یادگیری مقاوم (Robust Learning): آموزش مدلها با دادههای متنوع و شبیهسازی حملات خصمانه، مقاومت سیستم را افزایش میدهد.

۲. اعمال کنترلهای دسترسی سختگیرانه: محدود کردن دسترسی به سرورها و مدلهای AI تنها به کاربران مجاز.

۳. ارزیابی مستمر امنیتی: انجام تستهای نفوذ و بررسی آسیبپذیریها به صورت دورهای.

۴. شفافسازی مدلها: توسعه چارچوبهایی مانند XAI (هوش مصنوعی توضیحپذیر) برای درک بهتر فرآیندهای تصمیمگیری.

۵. همکاری با نهادهای قانونی: پیادهسازی استانداردهایی مانند ISO 27001 برای مدیریت امنیت اطلاعات.

طبق گزارش Perception-Point، ترکیب راهکارهای فنی (مانند رمزنگاری) و فرهنگ سازمانی (مانند آموزش کارمندان) میتواند تا 80% از حملات سایبری به سیستمهای AI را کاهش دهد.

نتیجهگیری: آینده امنیت هوش مصنوعی در دستان ماست

مشکلات امنیتی هوش مصنوعی به اندازه مزایای آن واقعی و جدی هستند. اما با رویکردی پیشگیرانه، آموزش مستمر، و همکاری بینالمللی، میتوانیم از این فناوری به شکلی ایمن و مسئولانه استفاده کنیم. چه یک کاربر عادی باشید و چه یک سازمان، امنیت هوش مصنوعی مسئولیتی جمعی است که نیازمند توجه فوری است. با رعایت این اصول، نه تنها از حریم خصوصی خود محافظت میکنید، بلکه به ساخت آیندهای امن تر برای همه کمک خواهید کرد.